在SEO 的世界裡,網站頁面被Google 索引是提升可見度的關鍵。然而,許多網站管理者會發現,儘管自己建立了大量頁面,Google 卻只索引了極少數幾個。這可能是因為技術性SEO 問題,例如爬取受阻、內部連結不足或內容品質過低。本文將針對這些問題進行深入剖析,並提供有效解決方案,讓你的網站獲得更多索引。

1. 網站結構與內部連結的缺陷

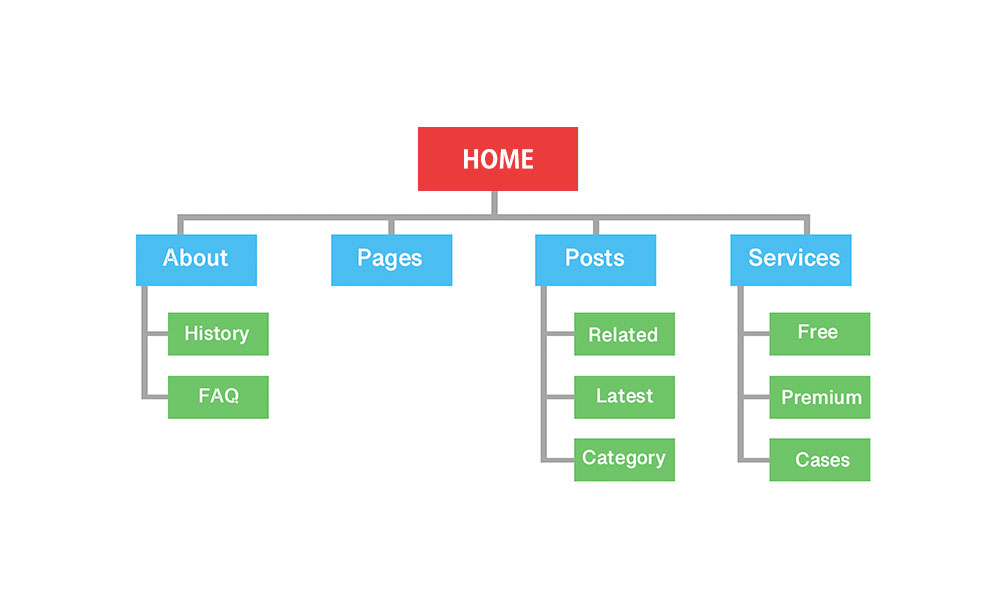

Google 無法索引某些頁面的最常見原因之一是網站結構不清晰,導致搜尋引擎無法有效爬取。

缺少內部連結

內部連結是幫助搜尋引擎理解網站架構的重要因素。如果你的頁面之間沒有適當的連結,Googlebot 可能無法找到這些頁面,進而導致索引問題。

✅ 解決方案:

- 建立清晰的 階層式網站架構,讓主要頁面與子頁面有適當的連結。

- 增加內部連結,讓搜尋引擎與使用者更容易找到頁面。

- 使用麵包屑導航(Breadcrumbs),幫助搜尋引擎理解頁面關係。

錯誤的 Sitemap 設置

網站有兩個 Sitemap,其中一個是錯誤的。儘管正確的 Sitemap 被列在 robots.txt 中,但它只包含網站主導航,並未涵蓋動態生成的頁面。

✅ 解決方案:

- 確保 Sitemap.xml 完整涵蓋所有重要頁面。

- 在 Google Search Console 中提交 Sitemap,並定期更新。

2. Robots.txt 設定錯誤,影響爬取

在 robots.txt 文件中,如果對所有搜尋引擎機器人(User Agents)都設置了 Disallow 指令,Googlebot 便無法爬取網站內容。

✅ 解決方案:

- 確保

robots.txt允許搜尋引擎爬取重要頁面,例如:User-agent: * Disallow: /private/ Allow: /public/ - 檢查

robots.txt是否 錯誤封鎖了重要資料夾 或 特定類型的頁面。 - 使用 Google Search Console 的 URL 檢查工具 來確認 Google 是否可以正常存取。

3. 內容品質過低,導致無法索引

如果你的頁面內容過於單薄(Thin Content),缺乏原創性或價值,Google 可能會選擇不索引。

✅ 解決方案:

- 提供獨特且有價值的內容,避免重複或過於簡單的資訊。

- 最佳化關鍵字與內容結構,確保內容符合使用者搜尋意圖。

- 強化在地化內容,例如在地倉儲資訊、當地氣候對儲存的影響等,提高內容相關性。

4. 缺少 Canonical 標籤與 Meta Robots 設定

Canonical 標籤與 Meta Robots 標籤對於告知搜尋引擎頁面重要性與索引規則至關重要。如果這些標籤缺失或設定錯誤,可能導致搜尋引擎無法正確索引。

✅ 解決方案:

- 在 重複或相似內容 的頁面使用 Canonical 標籤,指向主要版本。

- 確保

meta robots標籤允許索引:<meta name="robots" content="index, follow"> - 避免 Noindex 標籤錯誤設置,導致 Google 無法索引。

5. 建立完整的區域性頁面架構

如果你的網站涉及多個地區,如倉儲資訊等,應該建立清晰的 URL 架構。例如:

✅ 正確的區域性 URL 結構:

https://example.com/usa/california/los-angeles/https://example.com/usa/texas/houston/

這樣能幫助搜尋引擎更容易理解並索引你的地區性頁面。

6. 透過當地媒體與外部連結增加信任度

除了技術性 SEO,提升網站的 外部信任度 也能幫助 Google 更快發現你的網站並增加索引率。

✅ 解決方案:

- 發佈在地新聞稿,讓當地媒體報導你的網站或服務。

- 參與論壇、社群討論,並在適當情況下提供網站連結。

- 建立在地化的合作與引用,例如當地企業或部落客。

結論

- 改善網站結構:清晰的 URL 層級與內部連結。

- 優化 robots.txt 與 Sitemap:確保搜尋引擎可以正常爬取。

- 提升內容品質:避免薄弱內容,增加獨特價值。

- 設定 Meta Robots 與 Canonical:確保正確引導搜尋引擎。

- 推動地方公關:透過外部連結與媒體報導提升信任度。

如果你的網站仍然無法獲得良好的索引結果,建議使用 Google Search Console 進一步診斷問題,並持續優化 SEO 策略。透過以上步驟,你的網站將更容易被 Google 索引,提升搜尋可見度與流量! 🚀